第 11 章:多模态视界:CLIP 与 ViT

核心观点:多模态(Multimodal)不是简单的”拼凑”,而是真正的”融合”。通过对齐文本空间和图像空间,AI 终于打破了感官的次元壁。

1. 引言:百闻不如一见

人类获取信息 80% 靠视觉。

如果 AI 只能读文字,它就是个瞎子博学士。

GPT-4o 的震撼之处,不仅在于它能说话,在于它能看懂你的视频,听懂你的语气。

要做到这一点,核心难题是:如何把”图像的像素”和”文本的语义”映射到同一个数学空间里?

2. 核心概念:CLIP (对齐大师)

2.1 文本与图像的罗塞塔石碑

OpenAI 发布的 CLIP (Contrastive Language-Image Pre-trainin

第 10 章:模型微调实战:LoRA 与 SFT

核心观点:如果通用大模型是”大学毕业生”,微调(Fine-tuning)就是”岗前培训”。LoRA 技术的出现,让原本需要几百万美元的微调成本,降低到了几百块人民币。

1. 引言:通才 vs 专才

GPT-4 什么都懂,但在写你们公司的”内部公文格式”时,可能总是写不对。

Prompt 工程可以解决一部分问题,但当规则太复杂、或者需要学习大量私有知识(Domain Knowledge)时,Prompt 就塞不下了。

这时你需要 SFT (Supervised Fine-Tuning,有监督微调)。

你要给模型看 1000 份完美的内部公文,让它内化这种风格。

2. 核心概念:LoRA (低

第 06 章:Agent 架构:Function Calling 与规划

核心观点:Agent = LLM + Memory + Planning + Tools。如果说 LLM 是大脑,那么 Agent 架构就是让大脑能够感知世界并改变世界的躯体。

1. 引言:从“聊天机器人”到“数字员工”

ChatGPT 刚出来时,它只能陪你聊天。

但如果你问它:“现在的天气怎么样?”它会说:“我的数据截止到 2023 年…”。

因为它没有工具。

Agent(智能体)的出现,标志着 AI 从 Passive (被动问答) 转向 Active (主动行动)。它不再只是生成文本,而是开始执行任务。

2. 核心概念:工具使用 (Tool Use)

2.1 Function Cal

第 05 章:提示词工程进阶:上下文与结构化

核心观点:提示词工程(Prompt Engineering)不是玄学,而是一门用自然语言进行编程的学科。它的核心在于管理模型的”注意力”和规范”输出格式”。

1. 引言:别再把 AI 当许愿池

很多人的 Prompt 是这样的:”帮我写个文案,要火。”

这是在许愿,不是在工程开发。

如果结果不好,不要怪 AI 笨,是你给的指令不够清晰。

大模型是一个概率预测机器。你的每一个字,都在改变下一个字出现的概率分布。

进阶 Prompt 的目标,就是最大化输出符合你预期的概率。

2. 核心概念:上下文学习 (In-Context Learning)

2.1 给例子,别只给定义

LLM 具备一种神奇

第 04 章:RAG 进阶:重排序与混合检索

核心观点:RAG 系统的”最后一公里”决定成败。向量检索负责”广撒网”(Recall),而重排序(Rerank)负责”精挑选”(Precision)。

1. 引言:大海捞针的漏斗

上一章我们建立了向量索引。但你很快会发现一个问题:

用户搜:”谁是马斯克?”

向量检索可能召回:”马斯克的火箭”、”马斯克的汽车”、”马斯克的前女友”。

虽然都相关,但第一条可能并不是用户最想要的精确定义。

为了解决这个问题,我们需要一个漏斗系统:先用低成本的方法捞出一大堆,再用高成本的方法精细排序。

2. 核心概念:混合检索 (Hybrid Search)

2.1 为什么只有向量是不够的?

向量检索(Dense

第 03 章:RAG 基石:Embedding 与向量检索

核心观点:在 AI 的眼里,万物皆是坐标。RAG(检索增强生成)的本质,就是把用户的自然语言问题,映射到知识库的坐标系中,寻找最近的”邻居”。

1. 引言:计算机不懂中文,它只懂数学

你问 AI:”苹果怎么卖?”

在计算机底层,它根本不知道”苹果”是水果还是手机。

但如果你告诉它:”苹果”的坐标是 [0.8, 0.2],”香蕉”的坐标是 [0.85, 0.1],”卡车”的坐标是 [-0.5, 0.9]。

它会立刻计算出:苹果和香蕉很近,离卡车很远。

这就是 Embedding(向量化) —— 它是 RAG 系统地基中的地基。

2. 核心概念:Embedding Space (向量空间)

2

第 02 章:算力与推理工程:显存与量化

核心观点:在大模型推理中,搬运数据的时间远多于计算的时间。推理优化的核心战役,就是打破”内存墙”(Memory Wall)。

1. 引言:你的显卡为什么在”摸鱼”?

你买了昂贵的 RTX 4090,跑大模型时却发现 GPU 利用率只有 30%?

不要怪显卡,它很委屈。

它就像一个米其林三星大厨(Tensor Core 计算核心),切菜速度极快,但他必须等服务员从几公里外的仓库(显存 VRAM)把土豆一个一个搬过来。

大模型推理的瓶颈,通常不在算力(Compute Bound),而在显存带宽(Memory Bound)。

2. 核心概念:内存墙与 KV Cache

2.1 显存:寸土寸金的仓

第 01 章:大模型解剖学:参数与 Scaling Law

核心观点:大模型本质上是对人类知识的”有损压缩”。参数量决定了压缩的”分辨率”,而 Scaling Law 揭示了算力转化为智能的物理定律。

1. 引言:智能的”分辨率”

当我们谈论 7B、70B、671B 这些数字时,我们在谈论什么?

很多人认为参数量仅仅意味着”更大的硬盘”,存了更多的死记硬背的知识。大错特错。

参数量实际上代表了模型对世界认知的分辨率。就像一张 JPG 图片,像素越高,边缘越清晰;参数越多,模型对逻辑、因果、微妙情感的”边缘”刻画就越精准。

本章我们将拆解这个黑盒,看看智能是如何从这些浮点数中涌现的。

2. 核心概念:压缩即智能

2.1 这里的”压缩”不是 WinRA

第 20 章:系统架构与工程实践

“算法只是冰山一角,工程才是水面下的巨兽。”

恭喜你,你已经掌握了无监督学习的所有核心算法。

但在实际工作中,写出算法代码可能只占 10% 的时间。

剩下的 90% 时间,你在处理:数据管道、异常恢复、性能优化、成本控制。

本章将以一个典型的文本分析系统为例,剖析工业级数据挖掘系统的架构设计。

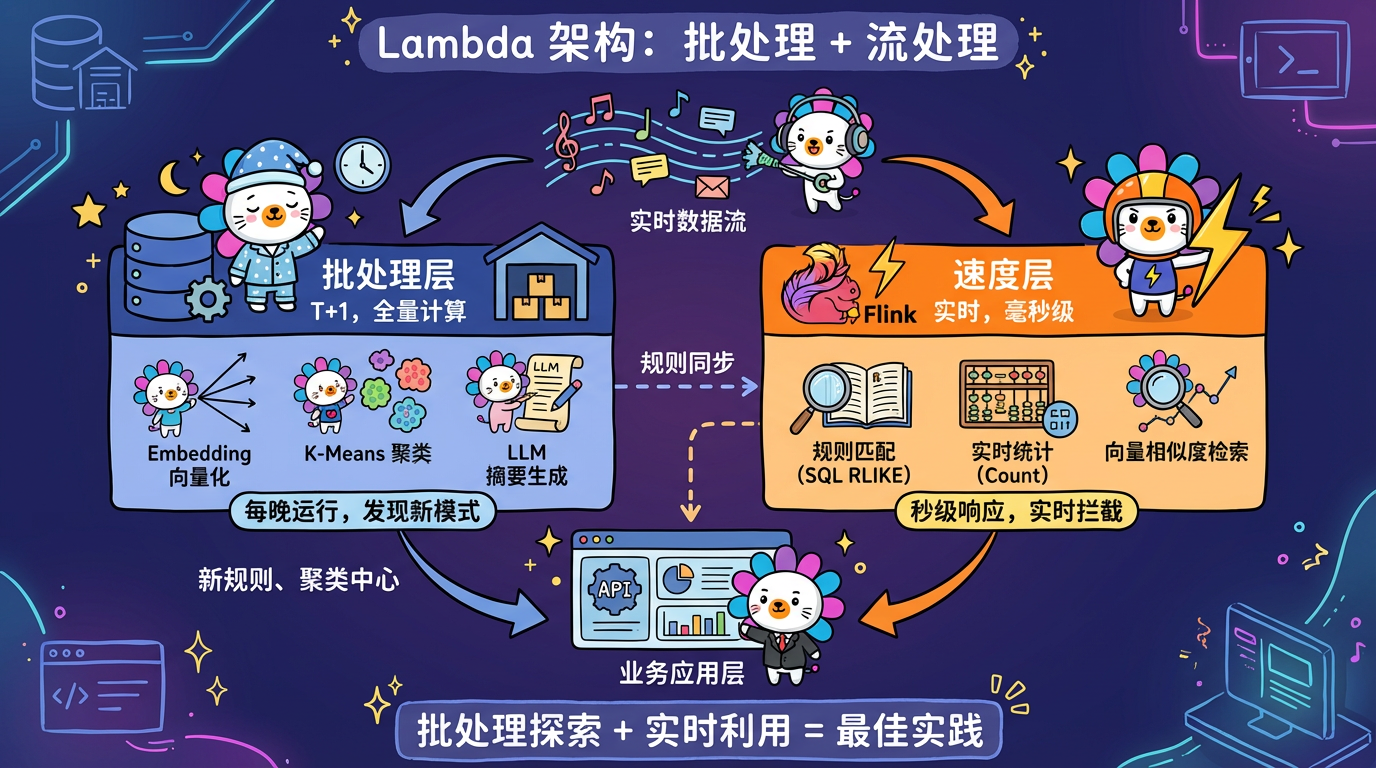

1. 核心概念:批处理 vs 流处理

1.1 批处理 (Batch Processing)

* 模式:T+1。每天凌晨把昨天的数据全量跑一遍。

* 适用:Embedding, KMeans, LLM 总结。这些算法很重,没法实时跑。

* 常见选择:文本分析系统通常采用批处理。因为”风险挖

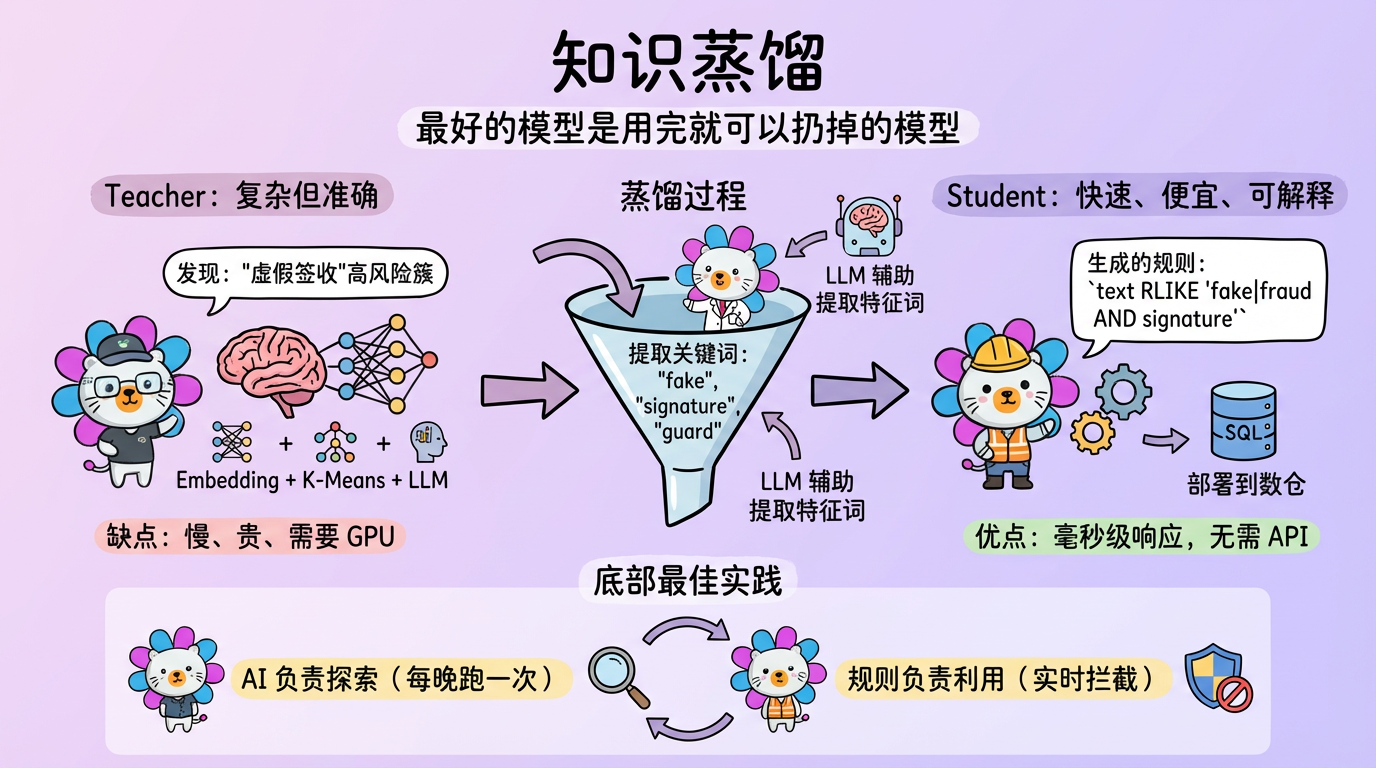

第 19 章:从模型到规则:知识蒸馏

“最好的模型,是用完了就可以扔掉的模型。”

在 Python 里跑完聚类和 LLM 之后,我们得到了深刻的洞察。

但 Python 脚本难以处理亿级的实时数据流。

我们需要把 Python/AI 学到的知识,转移到更轻量级、更高效的系统(如 SQL 引擎、规则引擎)中去。

这一过程被称为 知识蒸馏 (Knowledge Distillation),或者更具体地说,规则提取 (Rule Extraction)。

1. 核心概念:Model-to-Rule

1.1 为什么需要规则?

1. 性能:SQL RLIKE 比 Embedding 快一万倍。

2. 成本:不需要调 API,不需